معرفی Janus-Pro و بررسی دقیق آن – مدل جدید هوش مصنوعی دیپ سیک (Deepseek)

با همهی سر و صدایی که این روزها دربارهی DeepSeek V3 وجود داره، حالا وارد مرحلهی جدیدی از این مدلهای هوش مصنوعی میشیم؛ Janus-Pro، مدلی که میخواد چندبعدیتر و قدرتمندتر از همیشه باشه.

چیزی که توجهمون رو جلب کرد اینه که تیم دیپسیک به جای اینکه همهچیز رو از اول بسازه، همون تکنیکهای قدیمی رو برداشت و با آزمون و خطا، اونها رو دقیقتر و بهینهتر کرد. به جای اینکه چرخ رو از نو اختراع کنه، روی بهبود آموزش، گسترش دادهها و مقیاسپذیری تمرکز کرده و نتایجش واقعاً چشمگیره!

برای آشنایی با دیپ سیک و دیپ سیک V3 میتونین به مقاله معرفی DeepSeek Ai در بلاگ دیکاردو مراجعه کنین.

خرید API دیپ سیک از دیکاردو

دوست داری بدونی چطور میتونی از API دیپ سیک استفاده و اون رو با اپلیکیشن خودت ادغام کنی؟ میتونی مقاله همه چیز درباره DeepSeek API رو در بلاگ دیکاردو مطالعه کنی!

خب بریم ببینیم چه خبره:

چه چیز جدیدی در DeepSeek Janus هست؟

مدل جدید دیپسیک، Janus، که اسمش از خدای دوچهرهی روم باستان گرفته شده، سه تغییر کلیدی داره:

1- آموزش هوشمندتر: روش یادگیری مدل بهینهتر شده.

2- دادههای متنوعتر: این مدل با مجموعهای گستردهتر و عمیقتر از دادهها تغذیه شده.

3- مدل بزرگتر: مقیاس مدل بیشتر شده تا قدرتش بالاتر بره.

اما یه چالش بزرگ وجود داشت که باید حلش میکردن:

مشکل مدلهای چندوجهی

مدلهای هوش مصنوعی اخیراً پیشرفت زیادی در فهم و تولید تصاویر از متن داشتن. اما یه چالش وجود داره:

بیشتر مدلها از یه رمزگذار بصری یکسان برای درک و تولید تصاویر استفاده میکنن و این دو کار، نیاز به پردازشهای متفاوتی دارن و این باعث میشه که مدل بین کیفیت و سرعت یکی رو فدا کنه.

بیاید یه مثال بزنیم: فرض کنید یه سرآشپز بخواد هم غذای لذیذ بپزه، هم فست فود، اونم توی یه آشپزخونه. غذای لذیذ نیاز به زمان و دقت داره، ولی فست فود باید سریع آماده بشه. حالا اگه سرآشپز بخواد با یه روش، هر دو رو درست کنه، چی میشه؟ نتیجه نه اونقدر لذیذ میشه، نه اونقدر سریع!

همین اتفاق برای مدلهای هوش مصنوعی میافته. وقتی یه مدل فقط یک رمزگذار برای هم درک تصویر و هم تولیدش داشته باشه، نمیتونه توی هر دو مهارت عالی عمل کنه.

چطور این مشکل رو حل کردن؟

فکر میکنی با یه تکنولوژی خیلی پیچیده و عجیبغریب مشکل رو حل کردن؟ نه دقیقا! راز موفقیتشون توی یه طراحی هوشمندانه و استفاده از تجربههای قبلیه. تیم سازنده به جای اینکه از صفر شروع کنه، از مدل قبلی خودشون، Janus، کمک گرفتن. مدلی که همین مشکل رو تا حدی حل کرده بود، ولی هنوز جای پیشرفت داشت.

Janus چیه؟

جنس با یه ایدهی ساده اما کاربردی طراحی شد:

1- تفکیک رمزگذاری بصری: به جای اینکه یه روش واحد برای پردازش تصویر استفاده کنه، دوتا فرآیند جدا برای درک و تولید تصاویر داره.

2- تعادل بین دقت و سرعت: بدون اینکه یکی رو فدای اون یکی کنه، تلاش میکنه هر دو رو همزمان بهینه نگه داره.

اما خب، مثل هر تکنولوژی دیگهای، Janus هم محدودیتهایی داشت:

1- مدل خیلی کوچیک بود، فقط ۱ میلیارد پارامتر داشت، که باعث میشد قدرت پردازشش محدود بشه.

2- دادههای آموزشیاش خیلی متنوع نبودن، واسه همین عملکردش بعضی وقتها ناپایدار میشد.

3- اگه ورودیهای کوتاه یا مبهم بهش میدادی، خروجیهایی که میساخت کیفیت بالایی نداشتن.

یه مثال ساده: یه مترجم رو تصور کن که به دو زبان مسلطه، ولی فقط توی مکالمات روزمره تمرین کرده. حالا اگه یه متن ادبی پیچیده یا یه مقالهی علمی جلوش بذاری، ممکنه به مشکل بخوره. Janus هم همینطور بود؛ برای وظایف پیچیده، هنوز آماده نبود.

Janus-Pro: نسخهی پیشرفتهتر

برای حل این مشکلات، دیپسیک یه نسخهی قویتر و بهینهتر معرفی کرد: Janus-Pro. این نسخه توی سه زمینهی مهم پیشرفت کرده:

1- آموزش بهتر: مدل حالا روش یادگیری بهتری داره و سریعتر و عمیقتر آموزش میبینه.

2- دادههای متنوعتر: حالا با مجموعههای دادهی بزرگتر و باکیفیتتر آموزش داده شده.

3- مدل بزرگتر شده: دیگه محدود به ۱ میلیارد پارامتر نیست، نسخهی جدید ۷ میلیارد پارامتر داره که یعنی پردازش قویتر و خروجیهای بهتر.

حالا چی تغییر کرده؟ مدل دیگه فقط یه نمونهی آزمایشی نیست. روش جدید رمزگذاری و رمزگشایی بصری باعث شده که بتونه توی وظایف پیچیده عملکرد بهتری داشته باشه.

اما بزرگترین تغییری که DeepSeek توی Janus-Pro ایجاد کرده چیه؟

این همون جاییه که یه اتفاق جالب افتاده. بر خلاف چیزی که شاید انتظارش رو داشته باشی، اونا از اول همهچیز رو نساختن، فقط دو تا چیز رو تغییر دادن:

1- مدل رو با دادههای بیشتر و متنوعتر تغذیه کردن.

2- روش آموزش رو بهینه کردن تا کارآمدتر بشه.

یه مثال ساده: فرض کن یه ماشین عالی طراحی کردی، ولی میخوای سرعتش رو بیشتر کنی. لازم نیست کل ماشین رو از نو بسازی! کافیه موتور رو تقویت کنی، سوخت بهتری استفاده کنی و آیرودینامیکش رو بهینه کنی. دقیقا همون کاری که DeepSeek با جنس پرو کرد.

نتیجه؟ یه مدل که از قبل آشناست، ولی حالا سریعتر، دقیقتر و قویتر از همیشه عمل میکنه. بیاید یه نگاهی به معماری جنس Pro بندازیم:

معماری Janus-Pro

در نگاه اول، Janus Pro خیلی شبیه مدل قبلی، یعنی Janus به نظر میاد. ولی یه نکتهی مهم داره که حسابی جریان رو تغییر داده:

۱) جدا کردن بخش درک تصویر از بخش تولید تصویر

تو مدلهای قبلی، یه مشکل اساسی وجود داشت: یه رمزگذار باید هم عکس رو میفهمید، هم عکس میساخت. اما دیپسیک یه کار هوشمندانه کرد:

- برای فهمیدن تصویر یه روش داره

- برای ساختن تصویر یه روش دیگه

اما در نهایت، همهی اینا رو از یه ترانسفورمر عبور میده تا مدل یه درک کلی از تصویر داشته باشه.

چطوری کار میکنه؟

مرحله اول: فهمیدن تصویر (چطور مدل میفهمه چی توی عکس هست؟)

1- اول، یه رمزگذار به اسم SigLIP میاد و اطلاعات مهم تصویر رو استخراج میکنه.

2- بعد، این اطلاعات از یه حالت دوبعدی (مثلاً پیکسلهای عکس) به یه لیست عددی تبدیل میشن.

3- در نهایت، یه بخش دیگه که بهش میگن آداپتور این دادهها رو تبدیل میکنه به زبانی که مدل بتونه بفهمه.

اگه بخوام یه مثال بزنم، دقیقاً مثل اینه که بخوای یه نقشه رو بخونی.

وقتی ما یه نقشه میبینیم، جادهها و ساختمونها رو تشخیص میدیم. اما یه سیستم GPS نمیاد بگه “اینجا یه خیابونه، اونجا یه خونهست” بلکه همهچیز رو تبدیل میکنه به مختصات عددی تا راحتتر پردازش کنه.

این مدل هم دقیقاً همین کار رو با عکس انجام میده.

مرحله دوم: تولید تصویر (چطور مدل از متن، عکس میسازه؟)

1- یه چیزی به اسم توکنساز VQ عکس رو به تکههای کوچیک اطلاعات (یه چیزی مثل لگوهای دیجیتالی) تبدیل میکنه.

2- این اطلاعات وارد یه آداپتور دیگه میشن که اونها رو برای مدل زبان (LLM) آماده میکنه.

3- بعد، مدل از این تکههای اطلاعات استفاده میکنه تا عکس رو دوباره بسازه.

یه مثال خیلی ساده:

فرض کن یه موسیقیدان میخواد یه آهنگ رو اجرا کنه.

اگه فقط یه بار آهنگ رو بشنوه، ممکنه دقیق اجرا نکنه.

اما اگه نتهای موسیقی رو جلوش بذاری، راحت میتونه اونو دوباره اجرا کنه.

توکنساز VQ هم همین کار رو میکنه – عکس رو به “نتهای تصویری” تبدیل میکنه تا مدل بتونه دوباره اون رو از اول بسازه.

خب، چرا این کار مهمه؟

1- اگه یه رمزگذار هم عکس رو تحلیل کنه، هم عکس بسازه، ممکنه وسط کار گیج بشه و کیفیت خروجی خراب بشه.

2- اما وقتی این دو مرحله جدا باشن، دقت مدل خیلی بیشتر میشه و کیفیت تصاویری که تولید میکنه بالاتر میره.

دیپسیک با این روش تونسته یه مدل بسازه که هم بهتر تصاویر رو درک میکنه، هم تصاویر باکیفیتتری تولید میکنه. به جای اینکه یه سیستم همهفنحریف اما متوسط داشته باشیم، الان دو تا سیستم تخصصی داریم که هر کدوم کار خودشون رو عالی انجام میدن!

ب) استراتژی آموزشی: دقیقاً چی تغییر کرد؟

تا الان زیاد گفتیم که دیپسیک مدل رو بهتر آموزش داده، دادههای بهتری استفاده کرده و مقیاس رو افزایش داده. اما دقیقاً چی توی فرآیند آموزش تغییر کرد که نتیجه بهتر شد؟

بیاید ببینیم Janus (مدل قبلی) چطور آموزش داده میشد:

روش آموزش Janus (نسخه قبلی)

مدل سه مرحله داشت:

1- مرحله اول:

آداپتورها و بخشی که قراره تصویر رو پیشبینی کنه، آموزش داده میشدن.

2- مرحله دوم:

یه آموزش کلی برای مدل انجام میشد که تقریباً همهی اجزای مدل آپدیت میشدن، ولی رمزگذارهای اصلی تغییر خاصی نمیکردن.

3- مرحله سوم:

تنظیم نهایی، که توی این مرحله رمزگذار درک تصویر هم کمی اصلاح میشد.

اما تو مرحله دوم دو بخش خاص داشت که جالب بود:

1- مدل روی مجموعهای از دادههای ساده به نام ImageNet تمرین میکرد. توی این مرحله، فقط دستهبندیهای کلی مثل “سگ”، “ماشین” یا “درخت” به مدل داده میشد و باید متن و تصویر رو باهم یاد میگرفت.

2- مدل با دادههای واقعیتر و دقیقتر (یعنی توضیحاتی که دقیقتر توصیف میکنن چی توی تصویر هست) آموزش داده میشد.

نکته اینجاست که دو سوم آموزش مدل (۶۶.۶۷٪) فقط روی بخش اول تمرکز داشت!

مشکل این روش چی بود؟

خب، ایراد این روش این بود که مدل بیشتر روی دادههای ساده تمرین میکرد و از دادههای غنیتر و واقعیتر استفادهی کافی نمیکرد.

مثلا فرض کن یه نفر بخواد نقاشی یاد بگیره، ولی به جای اینکه بهش اجازه بدن نقاشیهای پیچیده تمرین کنه، فقط میگن:

“بیا این رنگها رو با هم ترکیب کن، ببین چه رنگی درمیاد!”

این هنرمند شاید بتونه رنگها رو خوب بشناسه، اما وقتی بخواد یه نقاشی واقعی بکشه، ممکنه مشکل داشته باشه!

مدل Janus هم همین مشکل رو داشت؛ بیشتر وقتش رو روی دادههای ساده و سطحی گذاشته بود، در حالی که باید بیشتر با دادههای توصیفی و واقعی تمرین میکرد تا واقعا تصاویر رو بفهمه!

چطوری آموزش Janus-Pro رو بهتر کردن؟

برای اینکه مدل عملکرد بهتری داشته باشه، دو تا تغییر مهم توی روش آموزش ایجاد کردن:

۱- آموزش پایهای طولانیتر (مرحله اول)

فرض کن یه ورزشکار بخواد توی یه رشته حرفهای بشه. اگه فقط تمرینای پیشرفته انجام بده، زود خسته میشه و پیشرفت خوبی نمیکنه. ولی اگه اول روی تمرینای پایهای مثل تقویت عضلات تمرکز کنه، بعداً توی تکنیکهای پیچیده هم خیلی بهتر عمل میکنه.

توی Janus Pro، مدت آموزش توی مرحلهی اول بیشتر شد تا مدل روی دادههای ImageNet تمرین بیشتری ببینه. حتی با همون تعداد پارامترهای مدل زبان (LLM)، این تغییر باعث شد مدل درک بهتری از پیکسلها داشته باشه و تصاویر معقولتری بسازه.

۲- تمرکز بیشتر روی دادههای واقعی در مرحله دوم

تصور کن بخوای آشپزی یاد بگیری. اگه فقط اسم مواد غذایی رو حفظ کنی، فایدهای نداره! باید همزمان شروع کنی به پختن غذا تا یادگیری سریعتر و بهتر بشه.

توی مدل قبلی، یه بخش از آموزش روی دادههای ImageNet بود (که بیشتر شامل کلمات ساده مثل “سگ” یا “ماشین” بود). اما حالا توی جنس پرو، این مرحله حذف شد و مدل مستقیم سراغ دادههای واقعی و دقیق متن-به-تصویر رفت (یعنی توضیحاتی که دقیقتر توصیف میکنن چی توی تصویر هست). این تغییر باعث شد آموزش مؤثرتر بشه و مدل بهتر بتونه از توضیحات متنی، تصاویر باکیفیت بسازه.

۳- تنظیم دقیق نسبت دادهها (مرحله سوم)

یه دانشجو رو در نظر بگیر که داره برای امتحانات آماده میشه. اگه فقط ریاضی بخونه و بقیه درسا رو ول کنه، توی بقیه مباحث ضعف پیدا میکنه. اما اگه وقتش رو بین همهی درسها تقسیم کنه، توی همهی زمینهها قوی میشه.

توی Janus-Pro، نسبت دادههایی که مدل باهاشون آموزش میبینه، بهتر تنظیم شده تا تعادل خوبی بین درک متن و تولید تصویر برقرار بشه.

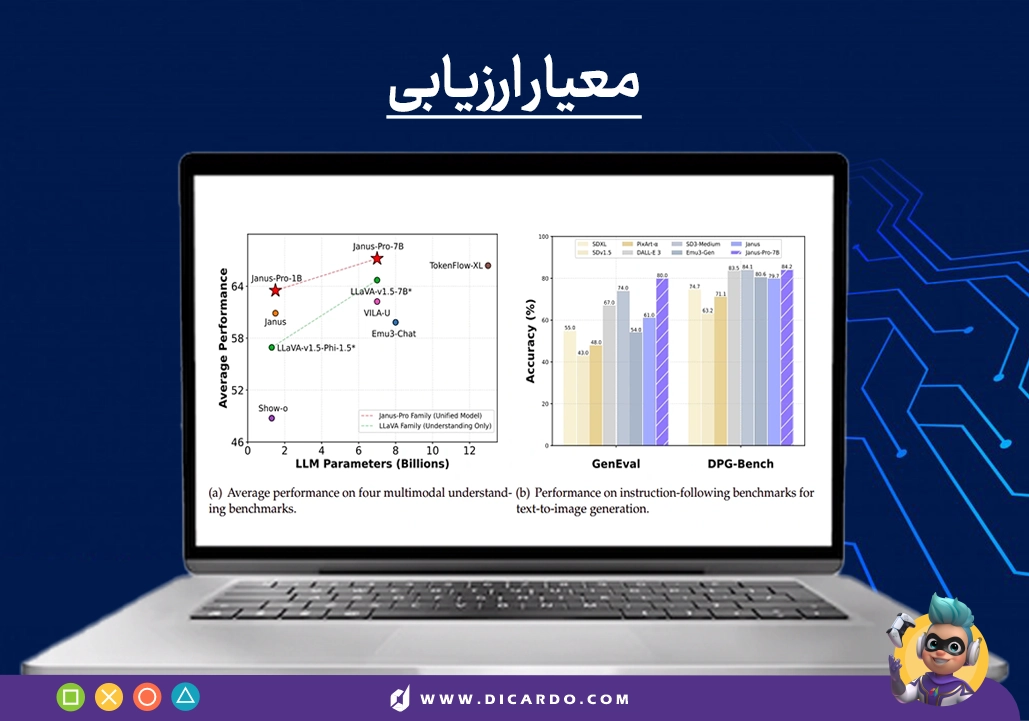

مقایسه نسبت دادهها در Janus و Janus-Pro:

| نوع داده | نسبت قبلی (Janus) | نسبت جدید (Janus-Pro) |

|---|---|---|

| دادههای چندوجهی | ۷ | ۵ |

| دادههای متنی خالص | ۳ | ۱ |

| دادههای متن به تصویر | ۱۰ | ۴ |

قبلاً مدل بیشتر روی دادههای متن-به-تصویر تمرکز داشت، ولی حالا تعادل بین دادههای مختلف بهتر شده. این تغییر باعث شد مدل همچنان تصاویر باکیفیت بسازه، ولی درکش از دادههای پیچیده و چندوجهی هم قویتر بشه.

حالا بریم سراغ مهمترین بخش ماجرا…

دادهها!

تیم DeepSeek فقط نیومدن روش آموزش رو تغییر بدن، بلکه دادههای آموزشی رو هم زیادتر و باکیفیتتر کردن. این تغییر تو دو بخش اصلی اتفاق افتاد:

۱- دادههای بیشتر برای درک بهتر تصاویر

برای اینکه مدل بتونه تصاویر رو دقیقتر درک کنه، حدود ۹۰ میلیون نمونه دادهی جدید بهش اضافه کردن.

خب، این دادههای جدید چی بودن؟

- دادههای توضیح تصویر (مثل YFCC): مدل یاد میگیره که با خوندن توضیحات، بفهمه توی عکس چه خبره.

- دادههای جدول، نمودار و سند (مثل Docmatix): مدل بهتر میتونه اطلاعات جدولها و اسناد پیچیده رو درک کنه.

- دادههای مربوط به میمها: به مدل کمک میکنه جوکها، طنز و معنی پنهان توی میمها رو بفهمه.

- دادههای مکالمه چینی: مدل توی صحبت کردن و تعامل به زبان چینی قویتر میشه.

- دادههای بهینهشده برای مکالمههای طبیعیتر: باعث میشه تعاملات مدل طبیعیتر و نزدیکتر به مکالمهی واقعی باشن.

چرا این کار مهمه؟

یه نفر رو تصور کن که فقط از روی کتابها انگلیسی یاد گرفته، ولی هیچوقت فیلم ندیده یا با کسی مکالمه نکرده! احتمالا وقتی یه جوک بهش بگی، درست متوجه نمیشه یا نمیتونه سریع جواب بده.

اما اگه علاوه بر خوندن کتاب، فیلم ببینه، جوک بشنوه و توی موقعیتهای واقعی قرار بگیره، خیلی بهتر میتونه زبان رو درک کنه.

Janus-Pro هم همین مسیر رو رفته؛ حالا به جای اینکه فقط از دادههای کلی یاد بگیره، با اطلاعات متنوعتر تمرین میکنه و درک تصویری قویتری داره!

۲- دادههای بهتر برای ساختن تصاویر باکیفیتتر

یکی از مشکلات نسخهی قبلی (Janus) این بود که دادههای تصویری واقعی زیادی بینظم و پر از نویز بودن. این باعث میشد که:

1- تصاویر مدل بعضی وقتا ناپایدار و بههمریخته باشن.

2- کیفیت تصویری که مدل تولید میکرد پایین باشه.

چطور این مشکل رو حل کردن؟

1- اضافه کردن ۷۲ میلیون تصویر مصنوعی باکیفیت.

2- متعادل کردن نسبت دادههای واقعی به دادههای مصنوعی (۱:۱).

چرا دادههای مصنوعی مفیدن؟

1- تمیزتر و دقیقترن: پس مدل راحتتر و بهتر یاد میگیره.

2- کمتر دچار خطا میشه: باعث میشه تصاویر نهایی ثبات بیشتری داشته باشن.

3- مدل سریعتر پیشرفت میکنه: چون با دادههای کنترلشده تمرین میکنه.

مثال ساده: چرا این کار جواب میده؟

فرض کن یه آشپز فقط از روی غذاهای خونگی یاد بگیره، اما هیچوقت توی یه آشپزخونهی حرفهای کار نکنه. نتیجه؟ ممکنه کلی عادت اشتباه توی پختوپز یاد بگیره که کیفیت کارش رو پایین میاره.

اما اگه بره توی یه رستوران حرفهای کار کنه، با تکنیکهای درست آشنا میشه و غذای باکیفیتتری درست میکنه.

دیپسیک هم همین کارو کرد. با ترکیب دادههای واقعی و دادههای مصنوعی باکیفیت، مدلش حالا میتونه تصاویر دقیقتر، طبیعیتر و چشمنوازتر بسازه.

نتیجه چطوری شد؟

1-حالا Janus-Pro نسبت به مدل قبلی خیلی بهتر تصاویر رو درک میکنه.

2- تصاویری که میسازه پایدارتر، زیباتر و واقعیتر شدن.

مدل بزرگتر، سریعتر و قویتر!

توی نسخهی قبلی (Janus)، مدل فقط ۱.۵ میلیارد پارامتر داشت و بیشتر برای آزمایش ایدهها طراحی شده بود. اما حالا توی Janus-Pro این عدد به ۷ میلیارد پارامتر رسیده.

خب، مدل بزرگتر چه فرقی ایجاد میکنه؟

1- یادگیری سریعتر: مدل راحتتر الگوها رو درک میکنه و آموزش بهینهتر میشه.

2- عملکرد قویتر: هم توی فهمیدن تصاویر و هم توی ساختنشون پیشرفت زیادی داره.

3- بهتر شدن مقیاسپذیری: نشون میده که ایدهی رمزگذاری جداشده روی مدلهای بزرگتر هم جواب میده.

یه مثال ساده:

این افزایش مقیاس، مثل اینه که یه تیم استارتاپ کوچیک تبدیل بشه به یه شرکت بزرگ با کلی کارمند و تجهیزات پیشرفته!

هرچی تیم بزرگتر باشه، وظایف راحتتر و دقیقتر انجام میشن و شرکت میتونه با مشکلات پیچیدهتر بهتر کنار بیاد.

جزئیات فنی، ولی به زبان ساده!

خب بیاین باهمدیگه این جزئیات رو بررسی کینم:

۱- مدل زبان (DeepSeek-LLM 1.5B & 7B)

- میتونه دستورات خیلی طولانی و پیچیده رو بفهمه و پردازش کنه (تا ۴۰۹۶ توکن). یعنی اگه یه سوال خیلی مفصل ازش بپرسی، دیگه وسطش گیج نمیشه و میتونه جواب کاملی بده.

۲- رمزگذار درک بصری (SigLIP)

- این بخش وظیفه داره قبل از اینکه تصویر به مدل زبان بره، اطلاعات مهمش رو استخراج کنه.

میتونی اینو مثل یه دوربین حرفهای در نظر بگیری:

یه دوربین ساده فقط رنگ و شکل رو میبینه، ولی یه دوربین حرفهای (مثلا DSLR) جزئیات دقیق، نور، سایه و عمق رو هم درک میکنه.

SigLIP هم همین کارو برای هوش مصنوعی انجام میده؛ یعنی تصویر رو دقیقتر بررسی میکنه و جزئیات بیشتری به مدل میده تا بهتر درکش کنه.

۳- رمزگذار تولید بصری

- این بخش از یه چیزی به اسم دفترچه کد با ۱۶۳۸۴ کد بصری استفاده میکنه. یعنی ۱۶۳۸۴ تا قطعهی کوچک تصویری که مدل میتونه ازشون برای ساختن یه عکس استفاده کنه. همچنین، برای تولید تصویر از نمونهبرداری با ضریب ۱۶ استفاده میکنه که باعث میشه هم سریعتر بشه، هم کیفیت حفظ بشه.

تصور کن یه عکس با کیفیت خیلی بالا داری ولی قراره اونو فشرده کنی که حجمش کمتر بشه.

1- اگه همهی جزئیات رو نگه داری، حجمش خیلی زیاد میشه.

2- اگه زیادی فشردهش کنی، کیفیت افتضاح میشه.

ولی یه روش هوشمند اینه که فقط بخشهای مهم رو نگه داری و بقیه رو حذف کنی، طوری که تصویر همچنان واضح و خوشگل بمونه.

رمزگذار تولید بصری دقیقا همین کارو انجام میده؛ تصاویر رو هوشمندانه فشرده میکنه و بازسازیشون رو بهینهتر میکنه.

خلاصهی کار چیه؟

1- مدل جدید بزرگتر، سریعتر و قویتره، هم توی درک تصاویر و هم ساختنشون.

2- مقیاسپذیری مدل بهتر شده، یعنی این روش حتی روی مدلهای خیلی بزرگتر هم جواب میده.

3- حالا تصاویر با جزئیات بیشتر و کیفیت بالاتر ساخته میشن، بدون اینکه پردازش مدل کند بشه.

پردازش تصویر و بهینهسازی آموزش

مدل برای اینکه بهترین عملکرد رو توی درک و تولید تصاویر داشته باشه، باید بتونه تصاویر رو استاندارد و یکدست پردازش کنه.

برای این کار، دیپسیک چند تا تغییر مهم توی نحوهی پردازش تصاویر انجام داده:

1- همهی تصاویر به اندازهی ۳۸۴×۳۸۴ پیکسل تبدیل میشن تا مدل بتونه اونا رو راحتتر پردازش کنه.

2- برای درک تصاویر: مدل یه پسزمینهی خاکستری (RGB: 127,127,127) به تصویر اضافه میکنه تا نسبت تصویر خراب نشه.

3- برای تولید تصاویر: عکسها مستقیماً به سایز ۳۸۴×۳۸۴ برش میخورن تا یه اندازهی استاندارد داشته باشن.

4- Sequence Packing: یه تکنیک هوشمند که کمک میکنه انواع مختلف دادهها بهطور همزمان پردازش بشن و آموزش سریعتر بشه.

چرا این تغییرات مهم هستن؟

1- تغییر اندازهی تصاویر: باعث میشه ورودیهای مدل همه یکدست باشن و مدل موقع یادگیری گیج نشه.

2- Padding (حاشیهگذاری با رنگ خاکستری): مدل رو قادر میکنه که تصاویر با اندازههای مختلف رو بدون کشیدگی یا تحریف پردازش کنه.

3- Sequence Packing: سرعت آموزش رو افزایش میده، چون مدل میتونه دادههای بیشتری رو توی هر مرحلهی آموزشی بررسی کنه.

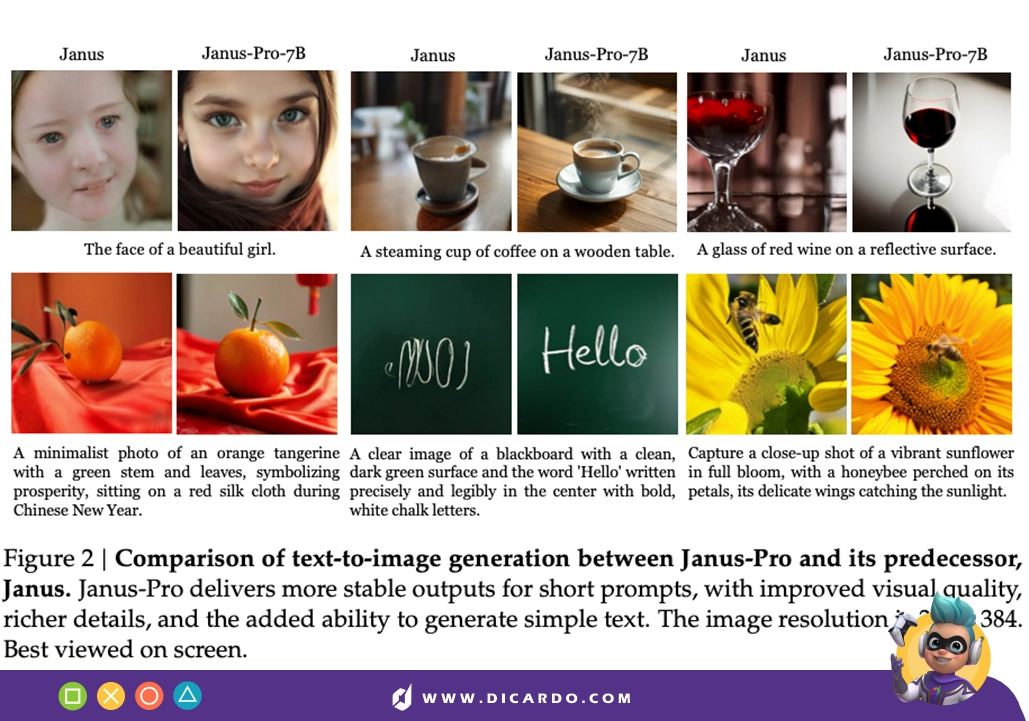

نمونه خروجیهای مدل

خب، مدل Janus-Pro چقدر خوب کار میکنه؟ بیاید یه نگاهی به خروجیهاش بندازیم:

۱- تشخیص متن از تصویر (OCR)

مدل میتونه متنهای نوشتهشده روی تصاویر رو بخونه و تشخیص بده. برای مثال، اگه یه تابلو توی یه عکس باشه که روش نوشته: “ورود ممنوع”، مدل میتونه اون متن رو تشخیص بده و بفهمه چی نوشته شده.

۲- سوال و جواب بر اساس تصویر (Visual Question Answering)

میتونی یه تصویر به مدل بدی و ازش سوال بپرسی مثلا یه عکس از یه منظرهی شهری نشونش بدی و بپرسی: “چند تا ماشین توی تصویر هست؟” و مدل سعی میکنه جواب بده

۳- تولید تصویر از متن (Text-to-Image)

مدل میتونه بر اساس یه توضیح متنی، تصویر بسازه. مثلا اگه بهش بگی: “یه گربهی سفید که روی مبل نشسته”، یه تصویر از همون صحنه برات میسازه

چرا این قابلیتها مهمن؟

1- OCR (تشخیص متن از تصویر): برای ترجمهی خودکار و پردازش اسناد کاربرد داره

2- سوال و جواب تصویری: میتونه توی جستجوی بصری، دستیارهای هوشمند و آنالیز عکسها خیلی مفید باشه

3- تولید تصویر از متن: یه ابزار خلاقانه برای طراحان، نویسندهها و تولیدکنندههای محتواست.

محدودیتهای مدل

Janus-Pro توی تولید تصاویر گرافیکی، توضیحات تصویر، دانش عمومی و تشخیص متن حسابی پیشرفت کرده، ولی خب، مثل هر مدل دیگهای، یه سری نقطهضعفهایی هم داره.

۱- وضوح تصویر پایینه

مدل فقط میتونه تصاویر رو با سایز ۳۸۴×۳۸۴ پیکسل بسازه. این یعنی جزئیات خیلی ظریف (مثل چهرهی آدمها یا نوشتههای خیلی ریز) ممکنه خوب از آب درنیان.

همچنین، این محدودیت باعث میشه تشخیص متن توی تصویر (OCR) دقت زیادی نداشته باشه.

۲- مشکل با ساختن تصویر از انسانها

اگه بخوای یه تصویر واقعی از یه آدم تولید کنی، مدل ممکنه نتیجهی عجیبوغریبی تحویلت بده! در نتیجه، این مدل برای برنامههایی که نیاز به تصاویر واقعی انسان دارن، خیلی ایدهآل نیست.

۳- دقت پایین توی وظایف پیچیده

چون وضوح تصویر بالایی نداره، توی وظایف دقیق مثل خوندن متن از روی عکس یا تحلیل تصویری پیشرفته، خیلی قوی عمل نمیکنه. مثلا اگه یه سند دستنویس رو بهش بدی و ازش بخوای متنش رو بخونه، احتمال داره چند تا کلمه رو اشتباه تشخیص بده.

۴- همیشه بهترین گزینه نیست

درسته که Janus-Pro توی بعضی موارد از رقبایی مثل DALL·E 3 بهتر عمل میکنه، ولی همچنان مدلهایی مثل Stable Diffusion یا DALL·E 3 کیفیت تصویر بالاتری ارائه میدن. یعنی اگه هدف اصلیات فقط تولید عکسهای باکیفیت باشه، ممکنه مدلهای دیگه گزینههای بهتری باشن.

پس Janus-Pro مدل خیلی خوبیه، ولی محدودیتهایی داره که باعث میشه توی بعضی کاربردها نتونه بهترین عملکرد رو داشته باشه.

حرف آخر

یکی از مهمترین درسهایی که Janus Pro و دیپ سیک R1 بهمون نشون دادن اینه که پیشرفت توی هوش مصنوعی همیشه نیاز به تغییرات انقلابی نداره.

گاهی اوقات، همون چیزی که از قبل داشتیم، فقط نیاز به یه سری تنظیمات هوشمندانه و بهینهسازی داره!

سازندهها معماری مدل رو تغییر ندادن، ولی روش آموزش رو هوشمندانهتر کردن. رمزگذار درک و تولید تصویر رو جدا کردن و یه گلوگاه بزرگ رو برطرف کردن، استراتژی آموزشی و دادهها رو بهینه کردن و یادگیری رو کارآمدتر کردن.

نتیجه؟ Janus-Pro حالا یه قدم بزرگ به سمت هوش مصنوعی چندوجهی واقعی برداشته. این فقط یه مدل جدید نیست؛ یه مسیر جدید برای مدلهای آیندهست.

پس این تازه شروع ماجراست. بیاین باهمدیگه منتظر بعدیها باشیم!

امیدواریم از خوندن این در بلاگ دیکاردو مقاله خوشتون اومده باشه. خوشحال میشیم که از نظراتتون بهره ببریم. موفق باشین.